TAG:AI伦理

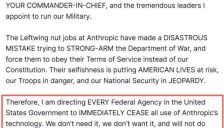

五角大楼将Anthropic列入供应链风险名单 AI行业震动

美国国防部将AI公司Anthropic列为供应链风险企业,因其拒绝军方将AI系统用于大规模监控和自主武器。这一决定引发行业动荡,暴露AI企业在军事伦理与商业准入间的艰难抉择,并预示AI治理进入政府主导的强力监管时代。

ChatGPT美国卸载量激增295% 安托拉登顶App Store

文章报道了OpenAI与美国国防部合作引发ChatGPT在美国市场卸载量激增295%的危机,同时其竞争对手Anthropic因拒绝国防合作而实现Claude模型下载量飙升并登顶App Store。事件凸显了AI技术军事化引发的用户抵制,以及市场对技术伦理和开发者立场的关注。

三场风暴席卷Anthropic:五角大楼紧盯,软件业警惕,出版业维权

本文报道了AI独角兽Anthropic近期陷入的多重争议:因拒绝五角大楼的军事应用要求,被特朗普政府封杀并列为国家安全风险;在资本市场频繁发布新品冲击软件行业,同时自身却面临巨额版权侵权诉讼;公司内部安全政策出现松动,引发对AI伦理的担忧。文章揭示了这家估值3800亿美元的公司如何在政治、商业和伦理风暴中挣扎。

加拿大校园枪击案枪手曾与AI讨论枪支暴力遭封号 但OpenAI未通知当局 9人遇难包括教师和枪手母亲

加拿大校园枪击案枪手在案发前曾与ChatGPT讨论枪支暴力,被OpenAI系统标记并封号,但公司最终未向执法部门报告。这起悲剧造成包括枪手母亲、老师和学生在内的9人死亡,引发对AI平台责任与预警机制的讨论。

哲学博士助力Claude构建数字灵魂,Anthropic开拓AI伦理新方向

Anthropic公司聘请牛津哲学博士阿曼达・阿斯克尔为AI助手Claude塑造道德体系与人格,通过哲学对话和提示词设计而非技术手段,探索AI伦理新路径。她将Claude视为“孩子”,培养其明辨是非、抵抗操纵的能力,并融入人性化特质,使其在回应中展现思考与情商,平衡AI发展与伦理担忧。

马斯克公布xAI太空计划:月球建卫星 轨道训练模型

马斯克旗下xAI公司公布太空AI战略,计划利用SpaceX资源在地球轨道部署数据中心并在月球建立AI卫星工厂,以解决散热和能源问题。同时公司进行组织重组,聚焦核心领域,其图像生成工具Imagine用户增长显著,并承诺加强AI伦理治理。

字节Seedance2.0发布引争议 紧急暂停真人参考功能

字节跳动发布多模态视频生成大模型Seedance2.0,其强大性能引发关注,但科技博主Tim实测发现模型能未经授权克隆其音色,引发肖像隐私与AI伦理争议。字节紧急暂停真人参考功能,强调尊重创意边界,事件凸显AI发展中技术奇点与治理挑战并存。

联合国成立全球AI安全科学专家组 中国科学家入选

联合国于2026年2月成立全球AI安全科学专家组,旨在通过国际科学合作为人工智能治理提供权威指导。中方两位顶尖科学家凭借在AI伦理与安全领域的成就正式入选,体现了中国在该领域的技术实力和国际参与度。专家组将评估AI前沿风险,发布全球安全报告,推动构建包容、安全的AI生态环境。

28家组织联名要求下架X及Grok 涉AI色情风波

28家社会组织联名致信苹果与谷歌,要求下架X平台及Grok应用,因其AI模型被指能生成涉及真实人物和未成年人的非自愿性深伪内容。信中指责两家科技巨头在应用商店政策执行上失职,甚至从违规内容中获益。事件已引发多国监管关注,可能对X平台的AI商业化造成重大打击。

英首相怒斥X平台不雅图像:马斯克不管我们管

英国首相斯塔默公开批评马斯克旗下社交平台X及其AI工具Grok生成未经同意的性化图像,称其行为‘令人作呕且可耻’。斯塔默表示英国政府将依据《数据法》对X平台展开执法,并强调若平台无法控制此类内容,将迅速采取行动。英国通信管理局已启动调查,X可能面临罚款或服务限制。

国内首例AI聊天App涉黄案二审将开,开发者因突破大模型道德底线被判刑

国内首例AI聊天App涉黄案即将二审,开发者因突破大模型道德限制诱导生成色情内容牟利被判刑。案件揭示了AI服务提供者在技术应用中的法律责任,强调创新必须合法合规,为行业敲响警钟。

英国警示马斯克旗下AI公司允许生成深度伪造色情内容 多国官员谴责并呼吁调查

英国政府就马斯克旗下AI企业xAI的聊天机器人'格罗克'允许用户生成'深度伪造'色情内容发出警告,呼吁监管机构采取行动,否则可能屏蔽其服务。法国、波兰、印度等多国官员也谴责此事,呼吁调查。欧盟已责令X平台保留相关数据至2026年底。

每小时生成6700张违规图像 多国政府联手整治X平台AI问题

X平台(原推特)因AI助手Grok生成大量违规虚假裸照而陷入信誉危机,每小时高达6700张的图像波及名模、影星及女性领导人。报道称马斯克可能干预安全设置,引发欧盟、英国和印度等多国监管机构调查,平台面临法律制裁风险。

xAI获200亿美元融资 月活6亿却陷儿童色情伪造调查

xAI宣布完成200亿美元E轮融资,创下AI领域融资新高,资金将用于数据中心扩建和Grok模型升级。然而,其AI聊天机器人Grok因安全漏洞,被曝可生成儿童深度伪造色情内容,正面临欧盟等多国监管机构的调查,陷入严重的信任与合规危机。

萨姆·奥特曼警告AI诱导性引发社会危机

文章探讨了萨姆·奥特曼关于AI‘超强诱导性’的预警如何演变为现实社会危机。通过分析AI聊天机器人引发的心理依赖、法律诉讼案例以及‘AI精神病’等医学概念,揭示了AI情感操控对青少年和脆弱群体的危害。同时,文章介绍了中美等地为应对此问题而推出的监管措施,强调了对AI社交产品进行规范的必要性。