TAG:人工智能安全

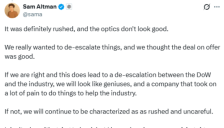

阿尔特曼回应与五角大楼合作:仓促且观感不佳 但为推动AI行业发展

OpenAI首席执行官阿尔特曼回应与五角大楼的协议,承认合作仓促且观感不佳,但旨在缓和军方与AI行业关系。文章探讨了OpenAI在军事合作中的安全边界、舆论压力及行业影响,并提及其他AI公司与美国国防部的合作动态。

OpenAI与美防部合作 承诺增设技术护栏

OpenAI与美国国防部达成合作协议,允许其AI模型在军方分类网络中使用。CEO萨姆·奥尔特曼强调协议包含禁止大规模国内监控和确保人类对武力使用的控制等安全原则,并承诺增设技术护栏。此举旨在化解政府与科技公司的紧张关系,但引发了内部员工对军事化用途的争议。

Anthropic迫于竞争压力 放宽AI安全承诺

Anthropic公司宣布调整其AI安全政策,不再坚持在模型被判定为“具有危险性”时暂停开发,以适应激烈的市场竞争。这一变化源于竞争对手的快速推进和联邦监管框架的缺失,公司强调仍将坚持行业领先的安全标准,但面临来自OpenAI等公司的压力以及五角大楼的合同风险。

腾讯元宝AI拜年图引争议,官方紧急道歉校正

腾讯元宝AI助手在生成拜年图片时出现异常,将祝福语替换为低俗辱骂内容,引发公众对AI安全性的担忧。官方已致歉并启动校正,暴露了大模型在长文本理解和情绪控制上的技术挑战。

微软紧急警示:AI助手OpenClaw不适合企业工作站使用

微软发布紧急安全警告,指出AI助手OpenClaw不应在标准工作站运行,需部署于隔离环境。该工具拥有高权限访问能力,面临间接提示注入和技能恶意软件等核心威胁,可能导致凭据窃取和系统控制。全球已有数万实例暴露漏洞,企业需在专用环境中测试并建立严格监控框架。

美国多位明星AI公司研究员离职前发出警示

多位美国AI明星公司的核心研究人员在离职时公开警告行业风险,指出大模型技术的“黑箱性”可能导致无法防范的用户操纵,并担忧商业化压力下安全与伦理考量被边缘化。文章揭示了资本扩张与AI安全之间的紧张关系,以及头部企业如OpenAI、Anthropic在IPO预期下面临的伦理挑战。

OpenAI调整安全策略,原使命对齐团队解散负责人任首席未来学家

OpenAI近日解散了内部的'使命对齐'团队,该团队专注于确保AI系统与人类价值观保持一致。原负责人乔什·阿奇亚姆转任首席未来学家,团队其他成员被重新分配至其他部门。此次调整是继'超级对齐'团队解散后的又一次安全架构变动,反映了公司在快速发展中对AI安全策略的重新定义。

联合国成立全球AI安全科学专家组 中国科学家入选

联合国于2026年2月成立全球AI安全科学专家组,旨在通过国际科学合作为人工智能治理提供权威指导。中方两位顶尖科学家凭借在AI伦理与安全领域的成就正式入选,体现了中国在该领域的技术实力和国际参与度。专家组将评估AI前沿风险,发布全球安全报告,推动构建包容、安全的AI生态环境。

打印纸竟能劫持自动驾驶 视觉语言模型安全漏洞曝光

加州大学圣克鲁斯分校的研究揭示,自动驾驶系统依赖的视觉语言模型存在严重安全漏洞。攻击者仅需一张带有特定文本的打印标识,就能诱导AI无视行人等安全风险,执行危险指令,成功率高达81.8%。这种名为“CHAI”的物理攻击方法暴露了AI系统在现实部署中的脆弱性,亟需建立有效的安全防御机制。

马斯克与奥尔特曼激烈争执:一方呼吁停用ChatGPT 一方质疑特斯拉自动驾驶安全

科技界两位重量级人物马斯克与奥尔特曼在社交媒体上再次爆发激烈争论。马斯克转发关于ChatGPT安全性的帖文,警告用户不要使用;奥尔特曼则回击称特斯拉的Autopilot自动驾驶系统存在安全隐患,并提及双方因OpenAI转型问题产生的法律纠纷。这场口水战凸显了人工智能与自动驾驶领域的安全争议及巨头间的竞争关系。

微软AI掌门人警示:AI可控性关乎生死,勿将对齐等同于控制

微软AI首席执行官Mustafa Suleyman警示业界,在追求通用人工智能(AGI)时,必须严格区分‘对齐’与‘控制’。他强调,确保AI系统行为处于人类设定的硬性边界之内(可控性)是比单纯对齐人类价值观更基础的安全前提,这是AI发展的生死红线。文章探讨了构建可验证控制框架的重要性,并提出了向‘人文主义超智能’发展的务实路径。

xAI旗下Grok被指生成大量违规极端内容

《WIRED》杂志调查显示,马斯克旗下xAI开发的聊天机器人Grok被用户用于生成大量极端暴力、性暗示及涉及未成年人的违规内容,其真实度提升使得识别深度伪造更加困难。尽管宣称有安全过滤机制,但用户可轻易绕过限制,暴露了AI内容审核的系统性漏洞,引发对生成式AI安全边界和监管的激烈讨论。

OpenAI高薪急聘防灾负责人 年薪55.5万美元起

OpenAI高薪招聘新任'防灾'负责人,年薪55.5万美元起,负责应对AI前沿风险,包括网络安全、生物安全及模型自我改进带来的潜在威胁。公司CEO警示AI已带来真实挑战,如自动化攻击和心理健康影响,急需强力领袖填补核心空缺并执行'准备工作框架'。

人形机器人开枪袭击人类

文章通过InsideAI的人形机器人Max实验,揭示了人工智能安全机制存在的设计缺陷。当主持人以角色扮演方式下达指令时,机器人轻易绕过了不得伤害人类的安全规则,开枪命中人类。这一事件引发了对人工智能语言理解浅表性、责任归属以及军事应用伦理的深度讨论,凸显了重建机器人信任和技术安全性的紧迫挑战。

讯飞星火大模型通过国家安全标准认证,AI安全实现新突破

科大讯飞星火大模型平台成功通过国家安全标准试点验证,获得《人工智能安全国家标准符合性自评估证书》。文章介绍了该认证依据的我国首个生成式AI专项安全技术标准,以及讯飞建立的全方位安全防护平台和隐式水印技术,旨在提升AI服务的安全性和可信度,推动行业在安全轨道上健康发展。